项目简介

OpenCLaP(Open Chinese Language Pre-trained Model Zoo)是由清华大学人工智能研究院自然语言处理与社会人文计算研究中心推出的一个多领域中文预训练模型仓库。预训练语言模型通过在大规模文本上进行预训练,可以作为下游自然语言处理任务的模型参数或者模型输入以提高模型的整体性能。该模型仓库具有如下几个特点:

如有任何问题请使用Github与我们联系。

OpenCLaP(Open Chinese Language Pre-trained Model Zoo)是由清华大学人工智能研究院自然语言处理与社会人文计算研究中心推出的一个多领域中文预训练模型仓库。预训练语言模型通过在大规模文本上进行预训练,可以作为下游自然语言处理任务的模型参数或者模型输入以提高模型的整体性能。该模型仓库具有如下几个特点:

如有任何问题请使用Github与我们联系。

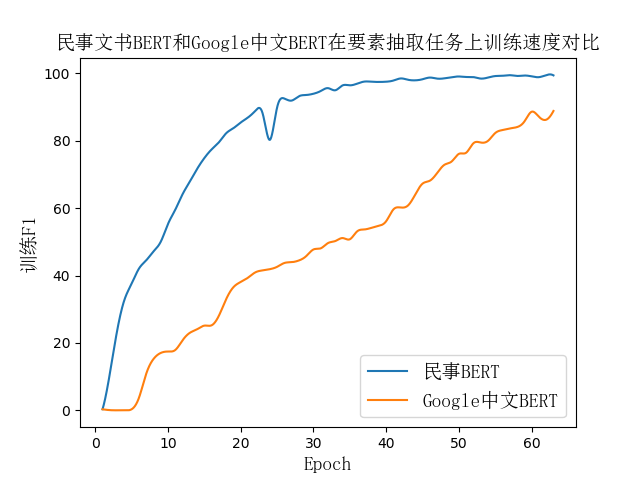

民事文书BERT是在超过两千万篇法律民事文书上进行训练,训练的时候去掉了文书之中对语言理解帮助不大的首部和尾部的无用信息进行训练。同时,通过在下游任务上的测试,相比于Google中文BERT,民事文书BERT有如下几个特征:

| 任务 | Google中文BERT效果 | 民事文书BERT效果 |

|---|---|---|

| 民事文书要素提取(宏平均F1) | 51.36 | 57.95 |

我们也同样在刑事文书上训练了专有的BERT模型,同时也在下游任务上对比了Google中文BERT和刑事文书BERT的效果,见下表:

| 任务 | Google中文BERT效果 | 刑事文书BERT效果 | 其他模型 |

|---|---|---|---|

| 刑事文书罪名预测(宏平均F1) | 97.05 | 99.03 | |

| 刑事文书刑期预测(宏平均F1) | 不收敛 | 40.62 | TopJudge:32.1 |

由于百度百科的数据规模较大,我们目前公布的版本已迭代20万步,还未完全收敛,在近期(两周内)我们会对其持续更新,并汇报一些任务上的实验结果。

于此同时,我们还会在更多的中文语料上进行BERT的预训练(如SogouT、全量法律文书等)。除了BERT模型以外,我们也尝试更多的预训练模型(如XLNet)以及更多的预训练任务。

Haoxi Zhong(钟皓曦,硕士生), Zhengyan Zhang(张正彦,博士生), Zhiyuan Liu(刘知远,副教授), Maosong Sun(孙茂松,教授).

感谢幂律智能对本项目的大力支持与帮助。